Le reti neurali profonde non vedono il mondo come lo vediamo noi

I sistemi sensoriali umani sono molto bravi a riconoscere gli oggetti che vediamo o le parole che sentiamo, anche se l’oggetto è capovolto o la parola è pronunciata da una voce che non abbiamo mai sentito.

I modelli computazionali noti come reti neurali profonde possono essere addestrati a fare la stessa cosa, identificando correttamente l’immagine di un cane indipendentemente dal colore della sua pelliccia, o una parola indipendentemente dal tono della voce di chi parla. Tuttavia, un nuovo studio condotto da neuroscienziati del MIT ha scoperto che questi modelli spesso rispondono allo stesso modo anche a immagini o parole che non hanno alcuna somiglianza con il bersaglio.

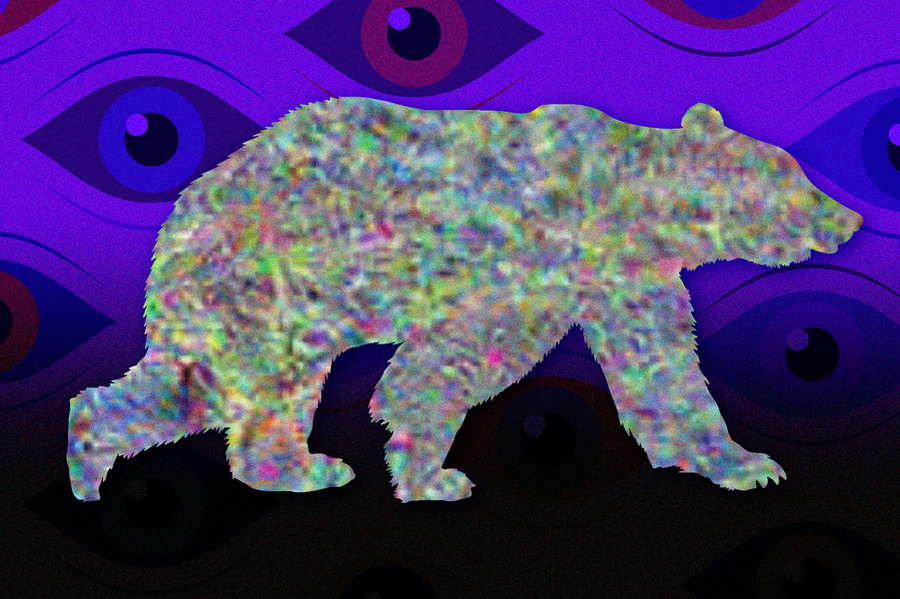

Quando queste reti neurali venivano utilizzate per generare un’immagine o una parola a cui rispondevano allo stesso modo di uno specifico input naturale, come l’immagine di un orso, la maggior parte di esse generava immagini o suoni irriconoscibili per gli osservatori umani. Ciò suggerisce che questi modelli costruiscono le proprie “invarianze” idiosincratiche, nel senso che rispondono allo stesso modo a stimoli con caratteristiche molto diverse.

I risultati offrono ai ricercatori un nuovo modo per valutare quanto bene questi modelli imitano l’organizzazione della percezione sensoriale umana, afferma Josh McDermott, professore associato di scienze del cervello e cognitive al MIT e membro del McGovern Institute for Brain Research e Center for Brains del MIT. , Menti e macchine.

“Questo articolo mostra che è possibile utilizzare questi modelli per ricavare segnali innaturali che finiscono per essere molto diagnostici delle rappresentazioni nel modello”, afferma McDermott, autore senior dello studio. “Questo test dovrebbe diventare parte di una serie di test che noi, come settore, stiamo utilizzando per valutare i modelli”.

Jenelle Feather PhD ’22, che ora è ricercatrice presso il Flatiron Institute Center for Computational Neuroscience, è l’autrice principale dell’articolo ad accesso aperto, che appare oggi su Nature Neuroscience . Anche Guillaume Leclerc, uno studente laureato del MIT, e Aleksander Mądry, professore di informatica Cadence Design Systems al MIT, sono autori dell’articolo.

Percezioni diverse

Negli ultimi anni, i ricercatori hanno addestrato reti neurali profonde in grado di analizzare milioni di input (suoni o immagini) e apprendere caratteristiche comuni che consentono loro di classificare una parola o un oggetto target con la stessa precisione con cui fanno gli esseri umani. Questi modelli sono attualmente considerati i principali modelli di sistemi sensoriali biologici.

Si ritiene che quando il sistema sensoriale umano esegue questo tipo di classificazione, impari a ignorare le caratteristiche che non sono rilevanti per l’identità fondamentale di un oggetto, come quanta luce splende su di esso o da quale angolazione viene visto. Questo è noto come invarianza, nel senso che gli oggetti sono percepiti come uguali anche se mostrano differenze nelle caratteristiche meno importanti.

“Classicamente, il modo in cui abbiamo pensato ai sistemi sensoriali è che essi creano invarianze rispetto a tutte quelle fonti di variazione che diversi esempi della stessa cosa possono avere”, afferma Feather. “Un organismo deve riconoscere che sono la stessa cosa anche se si presentano come segnali sensoriali molto diversi.”

I ricercatori si sono chiesti se le reti neurali profonde addestrate a svolgere compiti di classificazione potessero sviluppare invarianze simili. Per cercare di rispondere a questa domanda, hanno utilizzato questi modelli per generare stimoli che producono lo stesso tipo di risposta all’interno del modello come stimolo di esempio fornito al modello dai ricercatori.

Chiamano questi stimoli “metameri modello”, facendo rivivere un’idea della ricerca classica sulla percezione secondo la quale stimoli indistinguibili per un sistema possono essere utilizzati per diagnosticare le sue invarianze. Il concetto di metameri è stato originariamente sviluppato nello studio della percezione umana per descrivere colori che sembrano identici anche se sono costituiti da diverse lunghezze d’onda della luce.

Con loro sorpresa, i ricercatori hanno scoperto che la maggior parte delle immagini e dei suoni prodotti in questo modo non assomigliavano per niente agli esempi forniti originariamente dai modelli. La maggior parte delle immagini erano un miscuglio di pixel dall’aspetto casuale e i suoni somigliavano a rumori incomprensibili. Quando i ricercatori hanno mostrato le immagini agli osservatori umani, nella maggior parte dei casi gli esseri umani non hanno classificato le immagini sintetizzate dai modelli nella stessa categoria dell’esempio target originale.

“In realtà non sono affatto riconoscibili dagli esseri umani. Non sembrano né sembrano naturali e non hanno caratteristiche interpretabili che una persona possa utilizzare per classificare un oggetto o una parola”, afferma Feather.

I risultati suggeriscono che i modelli hanno in qualche modo sviluppato proprie invarianze diverse da quelle riscontrate nei sistemi percettivi umani. Ciò fa sì che i modelli percepiscano le coppie di stimoli come uguali nonostante siano molto diversi da un essere umano.

Invarianze idiosincratiche

I ricercatori hanno riscontrato lo stesso effetto in molti modelli visivi e uditivi diversi. Tuttavia, ciascuno di questi modelli sembrava sviluppare invarianze uniche. Quando i metameri di un modello venivano mostrati a un altro modello, i metameri erano altrettanto irriconoscibili per il secondo modello quanto lo erano per gli osservatori umani.

“La deduzione chiave da ciò è che questi modelli sembrano avere quelle che chiamiamo invarianze idiosincratiche”, afferma McDermott. “Hanno imparato a essere invarianti rispetto a queste particolari dimensioni nello spazio degli stimoli, ed è specifico del modello, quindi altri modelli non hanno le stesse invarianze.”

I ricercatori hanno anche scoperto che potrebbero indurre i metameri di un modello a essere più riconoscibili per gli esseri umani utilizzando un approccio chiamato addestramento contraddittorio. Questo approccio è stato originariamente sviluppato per combattere un’altra limitazione dei modelli di riconoscimento degli oggetti, ovvero che l’introduzione di modifiche piccole e quasi impercettibili a un’immagine può far sì che il modello la riconosca erroneamente.

I ricercatori hanno scoperto che l’addestramento contraddittorio, che prevede l’inclusione di alcune di queste immagini leggermente alterate nei dati di addestramento, ha prodotto modelli i cui metameri erano più riconoscibili per gli esseri umani, sebbene non fossero ancora riconoscibili come gli stimoli originali. Secondo i ricercatori, questo miglioramento sembra essere indipendente dall’effetto dell’addestramento sulla capacità dei modelli di resistere agli attacchi avversari.

“Questa particolare forma di allenamento ha un grande effetto, ma non sappiamo davvero perché abbia questo effetto”, dice Feather. “Questa è un’area per la ricerca futura.”

Secondo i ricercatori, l’analisi dei metameri prodotti dai modelli computazionali potrebbe essere uno strumento utile per aiutare a valutare quanto un modello computazionale imiti l’organizzazione sottostante dei sistemi di percezione sensoriale umana.

“Si tratta di un test comportamentale che è possibile eseguire su un determinato modello per vedere se le invarianze sono condivise tra il modello e gli osservatori umani”, afferma Feather. “Potrebbe anche essere utilizzato per valutare quanto siano peculiari le invarianze all’interno di un dato modello, il che potrebbe aiutare a scoprire potenziali modi per migliorare i nostri modelli in futuro”.

La ricerca è stata finanziata dalla National Science Foundation, dal National Institutes of Health, da una borsa di studio per laureati in scienze computazionali dell’energia e da una borsa di studio Friends of the McGovern Institute.