Un sistema universale per decodificare qualsiasi tipo di dato inviato in rete

Ogni pezzo di dati che viaggia su Internet, dai paragrafi di un’e-mail alla grafica 3D in un ambiente di realtà virtuale, può essere alterato dal rumore che incontra lungo il percorso, come l’interferenza elettromagnetica di un microonde o di un dispositivo Bluetooth. I dati sono codificati in modo tale che quando arrivano a destinazione, un algoritmo di decodifica possa annullare gli effetti negativi di quel rumore e recuperare i dati originali.

Dagli anni ’50, la maggior parte dei codici di correzione degli errori e degli algoritmi di decodifica sono stati progettati insieme. Ogni codice aveva una struttura che corrispondeva a un particolare algoritmo di decodifica molto complesso, che spesso richiedeva l’uso di hardware dedicato.

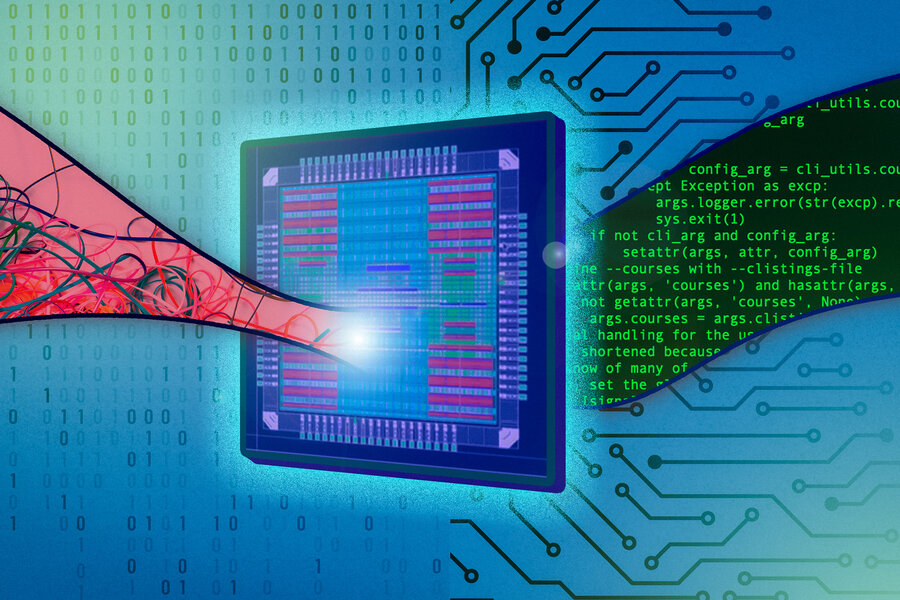

I ricercatori del MIT, della Boston University e della Maynooth University in Irlanda hanno ora creato il primo chip di silicio in grado di decodificare qualsiasi codice, indipendentemente dalla sua struttura, con la massima precisione, utilizzando un algoritmo di decodifica universale chiamato Guessing Random Additive Noise Decoding (GRAND) . Eliminando la necessità di più decoder computazionalmente complessi, GRAND consente una maggiore efficienza che potrebbe avere applicazioni in realtà aumentata e virtuale, giochi, reti 5G e dispositivi connessi che si basano sull’elaborazione di un volume elevato di dati con un ritardo minimo.

Concentrati sul rumore

Un modo per pensare a questi codici è come hash ridondanti (in questo caso, una serie di 1 e 0) aggiunti alla fine dei dati originali. Le regole per la creazione di quell’hash sono memorizzate in uno specifico codebook.

Quando i dati codificati viaggiano su una rete, sono influenzati dal rumore , o energia che interrompe il segnale, che è spesso generato da altri dispositivi elettronici. Quando quei dati codificati e il rumore che li ha colpiti arrivano a destinazione, l’algoritmo di decodifica consulta il suo codebook e utilizza la struttura dell’hash per indovinare quali sono le informazioni memorizzate.

Al contrario, GRAND funziona indovinando il rumore che ha influenzato il messaggio e utilizza il modello di rumore per dedurre le informazioni originali. GRAND genera una serie di sequenze di rumore nell’ordine in cui è probabile che si verifichino, le sottrae dai dati ricevuti e verifica se il codice risultante è in un codice.

Sebbene il rumore appaia di natura casuale, ha una struttura probabilistica che consente all’algoritmo di indovinare cosa potrebbe essere.

“In un certo senso, è simile alla risoluzione dei problemi. Se qualcuno porta la propria auto in officina, il meccanico non inizia mappando l’intera macchina su progetti. Invece, inizia chiedendo: ‘Qual è la cosa più probabile da fare? sbagliato?’ Forse ha solo bisogno di gas. Se non funziona, qual è il prossimo passo? Forse la batteria è scarica?” dice Medard.

Nuovo hardware

Il chip GRAND utilizza una struttura a tre livelli, partendo dalle soluzioni più semplici possibili nella prima fase e lavorando fino a modelli di rumore più lunghi e complessi nelle due fasi successive. Ogni fase funziona in modo indipendente, il che aumenta il rendimento del sistema e consente di risparmiare energia.

Il dispositivo è inoltre progettato per passare senza problemi tra due libri di codici. Contiene due chip di memoria statici ad accesso casuale, uno in grado di decifrare le parole in codice, mentre l’altro carica un nuovo libro di codici e quindi passa alla decodifica senza tempi di inattività.

I ricercatori hanno testato il chip GRAND e hanno scoperto che potrebbe decodificare efficacemente qualsiasi codice di ridondanza moderata fino a 128 bit di lunghezza, con solo circa un microsecondo di latenza.

Médard e i suoi collaboratori avevano precedentemente dimostrato il successo dell’algoritmo, ma questo nuovo lavoro mostra per la prima volta l’efficacia e l’efficienza di GRAND nell’hardware.

Lo sviluppo dell’hardware per il nuovo algoritmo di decodifica ha richiesto ai ricercatori di mettere prima da parte le loro nozioni preconcette, afferma Médard.

“Non potevamo uscire e riutilizzare le cose che erano già state fatte. Era come una lavagna completa. Abbiamo dovuto pensare davvero a ogni singolo componente da zero. È stato un viaggio di riconsiderazione. E penso che quando faremo il nostro prossimo chip, ci saranno cose con questo primo chip che ci renderemo conto di aver fatto per abitudine o per supposizione che possiamo fare di meglio”, dice.

Un chip per il futuro

Poiché GRAND utilizza solo i codici per la verifica, il chip non funziona solo con codici legacy, ma potrebbe anche essere utilizzato con codici che non sono stati ancora introdotti.

In vista dell’implementazione del 5G, le autorità di regolamentazione e le società di comunicazione hanno faticato a trovare un consenso su quali codici dovrebbero essere utilizzati nella nuova rete. I regolatori alla fine hanno scelto di utilizzare due tipi di codici tradizionali per l’infrastruttura 5G in situazioni diverse. L’utilizzo di GRAND potrebbe eliminare la necessità di quella rigida standardizzazione in futuro, afferma Médard.

Il chip GRAND potrebbe persino aprire il campo della codifica a un’ondata di innovazione.

“Per ragioni di cui non sono del tutto sicuro, le persone si avvicinano alla programmazione con timore reverenziale, come se fosse magia nera. Il processo è matematicamente sgradevole, quindi le persone usano semplicemente codici che esistono già. Spero che questo riformula la discussione in modo che sia non così orientato agli standard, consentendo alle persone di utilizzare codici già esistenti e creare nuovi codici”, afferma.

Andando avanti, Médard e i suoi collaboratori hanno in programma di affrontare il problema del rilevamento morbido con una versione riorganizzata del chip GRAND. Nel rilevamento morbido, i dati ricevuti sono meno precisi.

Hanno anche in programma di testare la capacità di GRAND di decifrare codici più lunghi e complessi e regolare la struttura del chip di silicio per migliorarne l’efficienza energetica.